部署快速入门¶

本指南将向您展示如何设置和使用 LangGraph 平台进行云部署。

先决条件¶

开始之前,请确保您具备以下条件:

- 一个 GitHub 账户

- 一个 LangSmith 账户 – 免费注册

1. 在 GitHub 上创建仓库¶

要将应用程序部署到 LangGraph 平台,您的应用程序代码必须位于 GitHub 仓库中。公有和私有仓库均受支持。对于本快速入门,请使用 new-langgraph-project 模板 作为您的应用程序

- 前往

new-langgraph-project仓库 或new-langgraphjs-project模板。 - 点击右上角的

Fork按钮,将仓库派生到您的 GitHub 账户。 - 点击 Create fork。

2. 部署到 LangGraph 平台¶

- 登录 LangSmith。

- 在左侧边栏中,选择 Deployments。

- 点击 + New Deployment 按钮。将弹出一个窗格,您可以在其中填写必填字段。

- 如果您是首次用户或要添加未曾连接过的私有仓库,请点击 Import from GitHub 按钮并按照说明连接您的 GitHub 账户。

- 选择您的 New LangGraph Project 仓库。

-

点击 Submit 进行部署。

这可能需要大约 15 分钟才能完成。您可以在 Deployment details 视图中查看状态。

3. 在 LangGraph Studio 中测试您的应用程序¶

您的应用程序部署完成后

- 选择您刚刚创建的部署以查看更多详细信息。

-

点击右上角的 LangGraph Studio 按钮。

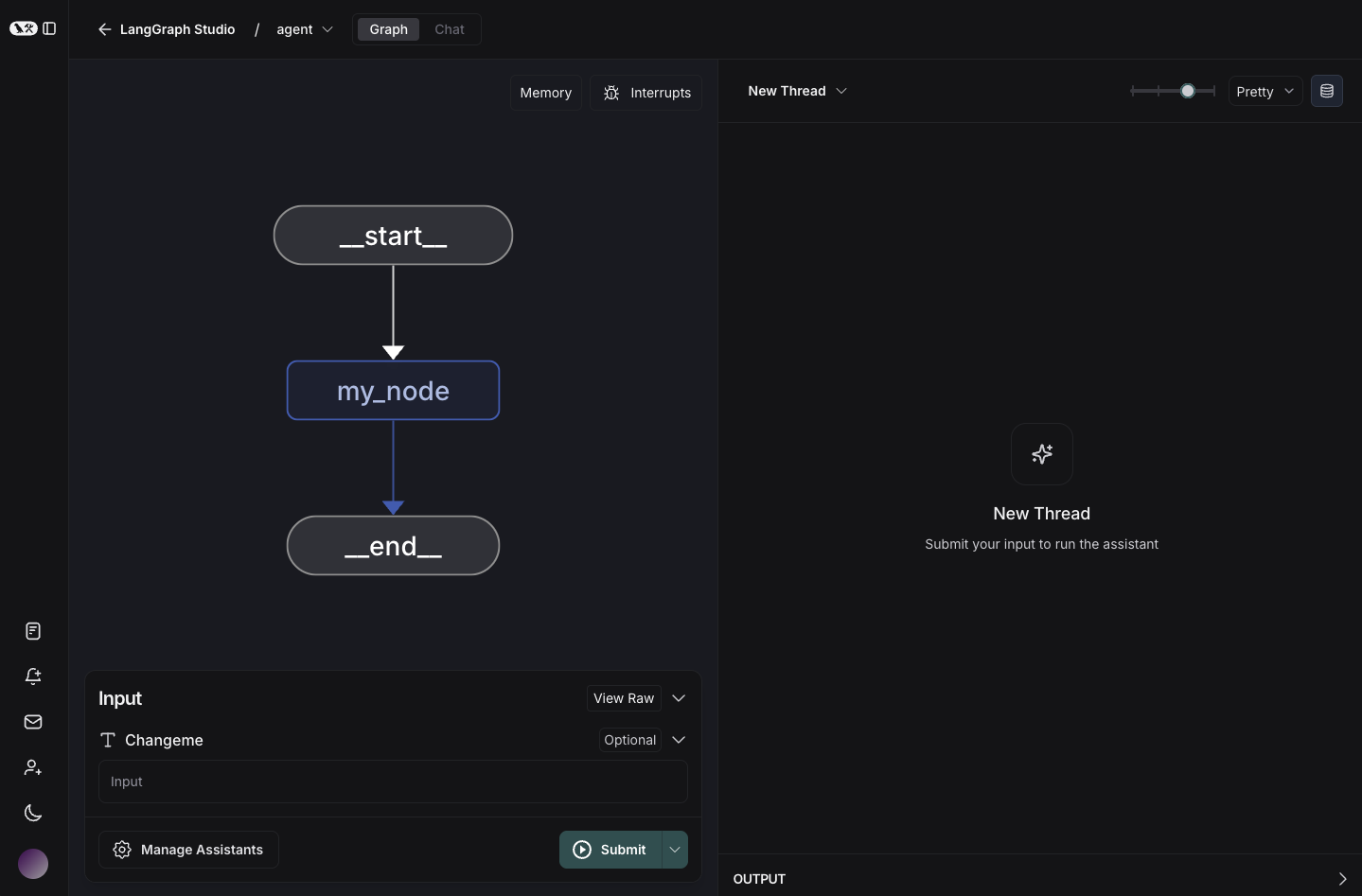

LangGraph Studio 将打开以显示您的图。

在 LangGraph Studio 中运行的示例图。

4. 获取部署的 API URL¶

- 在 LangGraph 的 Deployment details 视图中,点击 API URL 以将其复制到剪贴板。

- 点击

URL以将其复制到剪贴板。

5. 测试 API¶

您现在可以测试 API。

-

安装 LangGraph Python SDK

-

向助手发送消息(无线程运行)

from langgraph_sdk import get_client client = get_client(url="your-deployment-url", api_key="your-langsmith-api-key") async for chunk in client.runs.stream( None, # Threadless run "agent", # Name of assistant. Defined in langgraph.json. input={ "messages": [{ "role": "human", "content": "What is LangGraph?", }], }, stream_mode="updates", ): print(f"Receiving new event of type: {chunk.event}...") print(chunk.data) print("\n\n")

-

安装 LangGraph Python SDK

-

向助手发送消息(无线程运行)

from langgraph_sdk import get_sync_client client = get_sync_client(url="your-deployment-url", api_key="your-langsmith-api-key") for chunk in client.runs.stream( None, # Threadless run "agent", # Name of assistant. Defined in langgraph.json. input={ "messages": [{ "role": "human", "content": "What is LangGraph?", }], }, stream_mode="updates", ): print(f"Receiving new event of type: {chunk.event}...") print(chunk.data) print("\n\n")

-

安装 LangGraph JS SDK

-

向助手发送消息(无线程运行)

const { Client } = await import("@langchain/langgraph-sdk"); const client = new Client({ apiUrl: "your-deployment-url", apiKey: "your-langsmith-api-key" }); const streamResponse = client.runs.stream( null, // Threadless run "agent", // Assistant ID { input: { "messages": [ { "role": "user", "content": "What is LangGraph?"} ] }, streamMode: "messages", } ); for await (const chunk of streamResponse) { console.log(`Receiving new event of type: ${chunk.event}...`); console.log(JSON.stringify(chunk.data)); console.log("\n\n"); }

curl -s --request POST \

--url <DEPLOYMENT_URL>/runs/stream \

--header 'Content-Type: application/json' \

--header "X-Api-Key: <LANGSMITH API KEY> \

--data "{

\"assistant_id\": \"agent\",

\"input\": {

\"messages\": [

{

\"role\": \"human\",

\"content\": \"What is LangGraph?\"

}

]

},

\"stream_mode\": \"updates\"

}"

下一步¶

恭喜!您已使用 LangGraph 平台部署了一个应用程序。

以下是一些其他可查看的资源: